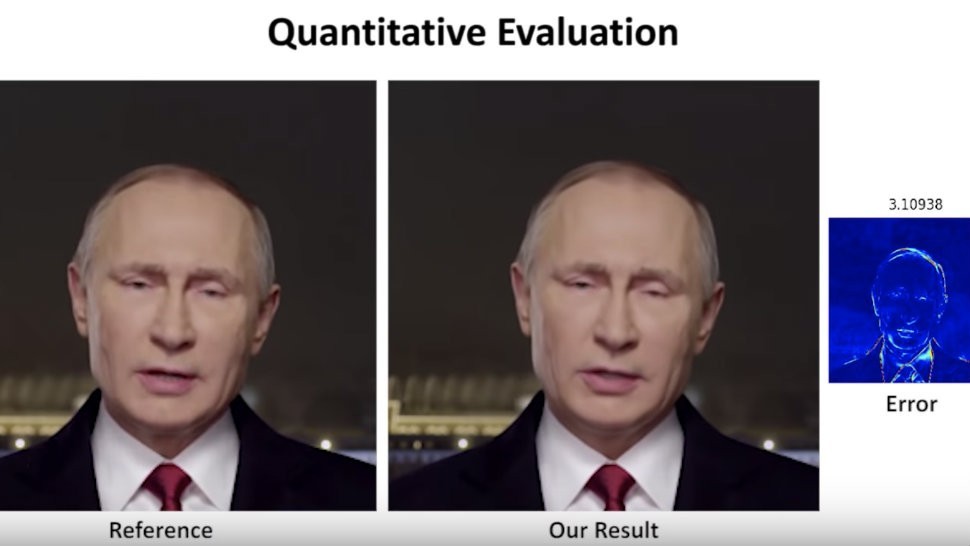

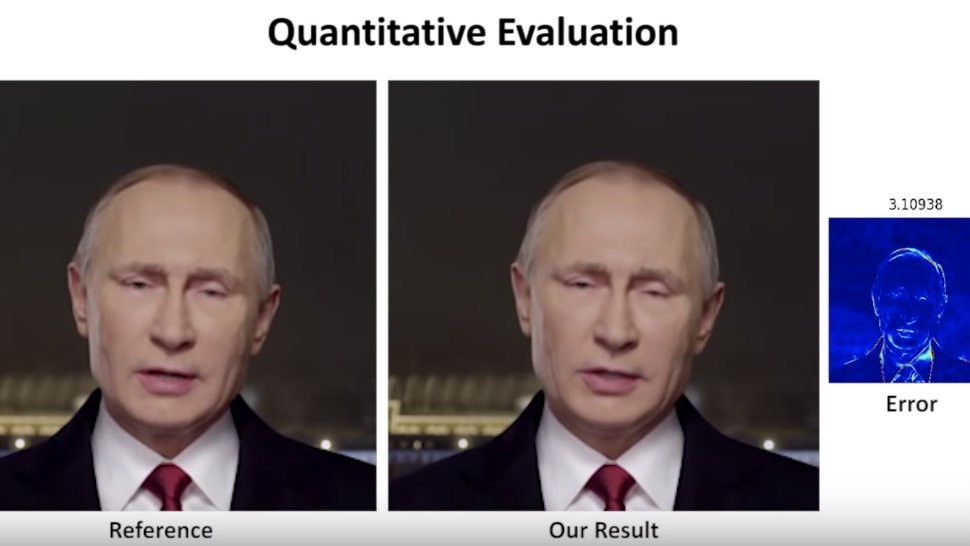

Deepfake, es un acronimo del inglés formado por las palabras fake, falsificación, y , deep learning, aprendizaje profundo. Es una técnica de Inteligencia artificial basada en sintetizar la imagen humana combinando y superponiendo ima genes creadas por ordenador, utilizando para ello: algoritmos de aprendizaje no supervisados conocidos, en español, como RGAs (Red generativa antagónica) y vídeos o ima genes ya existentes. El resultado final de dicha técnica es, generalmente, un video completamente falso, pero en muchos casos, lo bastante realista como para poder inducir a error y presentar como hechos algo que es pura ficción.

Tales vídeos de falsificación pueden ser creados , por ejemplo, sobre un actor o personaje del especta culo que aparecera en el vídeo falso participando en actos sexuales. El video falso es una combinación de un video pornogra fico ma s otro vídeo o imagen del actor o personaje convenientemente procesado por el programa informa tico con técnicas deepfake. No importa que el actor o personaje nunca haya realizado escenas o vídeos pornogra ficos, precisamente lo que se persigue es crear el efecto, lo ma s realista posible, de que algo así ha ocurrido. Debido a estas capacidades, los videos deepfakes acostumbran a crear falsificaciones pornogra ficas de celebridades aunque también son usados para falsificar noticias y crear bulos malintencionados. Valga decir que el origen de esta técnica fraudalenta tiene su origen en el mundo de la investigación con aplicaciones practicas en el mundo del cine. Por ejemplo, en la última película de la saga Star Wars, Carrie Fisher, la conocida princesa Leia ya había fallecido durante su rodaje, por lo que hubo que hacer uso de esta técnica. Gracias a los algoritmos RGA se pueden generar fotografías que parecen auténticas a observadores humanos. Por ejemplo, una fotografía sintética de un gato que consiga engañar al discriminador (una de las partes funcionales del algoritmo), es probable que lleve a una persona cualquiera a aceptarlo como una fotografía real.

FUENTE: Wikipedia

Inteligencia artificial, nuevo reto en la lucha contra ‘pornovenganza’

Expertas temen el impacto de una tecnología que permite poner cualquier rostro en videos porno.

Emma Watson, la protagonista de ‘La Bella y la Bestia’, es una de las famosas víctimas de contenidos pornogra ficos falsos con su rostro, conocidos como ‘Deepfakes’.

Miles de mujeres y organizaciones que luchan contra el mal llamado ‘porno de la venganza’ y que procuran frenar la difusión de contenidos sexuales sin el consentimiento de las víctimas recibieron esta semana un enorme reto: luchar contra los alcances de la inteligencia artificial. Y, específicamente, hacer frente a las capacidades de un programa que puede crear videos pornogra ficos realistas reemplazando las caras originales de los actores con otros rostros.

Los falsos videos pornogra ficos de Gal Gadot y otras artistas como Emma Watson, Taylor Swift y Ariana Grande son denominados popularmente como ‘Deepfakes’.

Salieron a la luz recientemente debido a las publicaciones de una comunidad de Reddit con ma s de 91.000 suscriptores donde se compartían estos montajes.

La reacción de la industria no se hizo esperar. Esta semana PornHub, Twitter y ma s recientemente Reddit -que se puso serio con una cuestión que inició en su plataforma- bloquearon los falsos videos pornogra ficos y buscara n eliminarlos de la red.

Los montajes no son algo nuevo. En diciembre, el portal MotherBoard informó que se había utilizado un algoritmo para crear videos falsos de la actriz de Wonder Woman Gal Gadot.

En enero, la pra ctica se popularizó después del lanzamiento de una herramienta de software llamada FakeApp, que usa inteligencia artificial para lograr el face swap(reemplazo de rostros), pero en video.

La función, que podría asemejarse a la de Snapchat con la que se pueden intercambiar dos rostros en una misma fotografía, logra unos resultados en video muy realistas, al simular también el movimiento, y lo hace con solo presionar un botón.

El uso de inteligencia artificial para crear ‘Deepfakes’ permite la generación de una versión computarizada de un sujeto y asemeja las expresiones originales de otra persona en un video. Según BBC, para trabajar una pieza se requiere una selección de ma s de 500 ima genes diferentes de la cara del sujeto, tomadas desde diferentes a ngulos.

Aunque la herramienta también se usa, por ejemplo, para continuar con una extraña tradición virtual de mofarse del actor Nicola s Cage, expertas en derechos de las mujeres y activistas han mostrado su preocupación frente al impacto destructivo que puede tener esta inteligencia artificial en la vida de las mujeres, especialmente quienes son vulnerables a ser víctimas de ‘sextorsión’ (pra ctica extorsiva que busca que una persona haga determinada acción para evitar la difusión de ima genes reales o montajes sexuales suyos).

El impacto de la viralización

Para Mónica Echeverría, directora del Observatorio de medios y género de la Universidad Central, aunque la tecnología es una herramienta que puede usarse para acciones positivas o negativas, el caso de FakeApp y los ‘Deepfakes’ son «una clara violación al respeto y al derecho a la intimidad». Adema s, a pesar de que herramientas como FakeApp requieran un considerable número de ima genes, algunas piezas de video y otros materiales pueden conseguirse a través de redes sociales.

«Aunque esta no es una afectación exclusiva de las mujeres, sin duda, son ellas las ma s afectadas frente a este tipo de violencia. Adema s, no se va a tratar solamente de mujeres media ticas y actrices sino que también chicas universitarias, profesoras, mujeres en la oficina, cuyos rostros van a ser usados para la ‘diversión’ de una manera tan indignante como la pornografía falsa» aseguró Echeverría.

Eliana Riaño, miembro de la Mesa por el Derecho de las Mujeres a una Vida Libre de Violencias y de la Red de Salud de las Mujeres Latinoamericanas, aseguró que en un contexto en el que los hombres son «aplaudidos» por mantener múltiples relaciones sexuales pero las mujeres no, cualquier mujer que desafíe los referentes sociales que le rodean «puede ser tildada de menos mujer o menos digna. Ninguna mujer quiere que le digan eso ni sentirse de esa manera» aseguró.

En algunos casos, mujeres que han sido víctimas de ‘sextorsión’ o de difusión de material sexual sin su consentimiento han llegado al suicidio. En el caso de Tiziana Cantone, en Italia, la mujer fue víctima de la difusión sin su consentimiento de un material que había accedido grabar anteriormente (para uso privado). La reacción virtual fue la justificación del acoso y la burla por haber dicho «¿esta s grabando? ¡Bravo!». Incluso, algunas personas imprimieron camisetas con la frase. Cantone se suicidó en 2016.

El caso de Amanda Todd es recordado por la viralización del video en el que la adolescente hablaba del ciberbullying del que era víctima y explicaba las razones de su suicidio. La joven había sido engañada para mostrar sus senos en una webcam y la imagen había circulado de forma masiva en internet.

Según Riaño, el impacto de difundir ima genes reales o montajes de las mujeres que exponen su intimidad sin su consentimiento es devastador y les puede llevar mucho tiempo recuperarse.

«Es un impacto profundo porque afecta todos los espacios de la vida de las mujeres: Adema s de la honra o la buena imagen, esto afecta el derecho a la integridad, a la igualdad, al reconocimiento de su intimidad, al libre desarrollo de la personalidad, a la libertad de expresión y hasta a decidir sobre si misma», aseguró.

Por otro lado, la experta apuntó que el exponer la intimidad sexual de una mujer podría justificar otras formas de violencia. Comentó que quienes sufren estos ataques dejan de ser contratados por las empresas. En el caso de las mujeres, algunas son expulsadas de sus casas. Otras abandonan las instituciones en las que se hicieron públicas sus ima genes. «Muchas deben irse de sus hogares, colegios, e incluso del país en el que han vivido siempre y pasa mucho tiempo mientras pueden llegar a reconfigurar múltiples aspectos de sus vidas«, dijo Riaño.

¿Por qué se comparten esos contenidos?

Según Ana María Moreno, directora de EnRedo, organización colombiana sin a nimo de lucro que trabaja en temas de socialización de TIC, FakeApp se ha convertido ra pidamente en una herramienta de acoso en línea y de una modalidad de agresión similar al ‘porno de venganza’. pero según Moreno la aplicación plantea un un agravante adicional «Al ser videos falsos entran en el a mbito de la difamación, en ambos casos afectando intencionalmente la reputación, intimidad y buena imagen de la víctimas, que hasta ahora han sido actrices y figuras públicas. Incluso podría implicar calumnia y difamación puesto que son personas puestas virtualmente en situaciones en las que nunca decidieron estar».

La viralización de los ‘Deepfakes’ también trae un debate sobre la facilidad con la que un determinado grupo utiliza la tecnología para difamar a otros.

La razón por la que la sociedad tiende a publicar este tipo de contenidos – afirmó Eliana Riaño – es que la virtualidad abre una puerta que aún no sabemos manejar: La posibilidad, por ejemplo, de violentar a otros sin recibir una sanción.

«Cualquiera puede abrir cuentas en redes sociales, subir un video como si nada y el material puede ser descargado y compartido en pocos minutos. Las personas no se detienen a pensar si un video donde aparece el cuerpo de una mujer (que no quería ser expuesta) es o no una violencia. Y eso es resultado de que a las mujeres se nos lee como un objeto. Una cosa con la que se puede hacer lo que quieran«, puntualizó Riaño.

Por su parte, Ana María Moreno explicó que otro problema es que los jóvenes empiecen a utilizarlo en contra de sus compañeros, puesto que los menores son sujetos de protección especial. «Por ejemplo, ¿cómo se manejaría si el rostro de una menor de edad es usado en un video porno falso, sería ‘pornografía infantil’? Si así fuera, es un delito y quien la distribuya podría ser considerado como un delincuente».

Este tipo de conductas en Colombia no son un delito tipificado aún. Según la Dijin, en el caso particular de un montaje, como los realizados para material ‘Deepfake’, se investiga una afectación a la honra y la buena imagen de la víctima y esos casos pueden ser denunciados a través del CAI virtual. Así mismo, en caso de que el material involucre a menores de edad, existe la línea de denuncia de la Red Te Protejo.

Según Mónica Echeverría, el caso de FakeApp también destaca la importancia de que se generen debates alrededor del uso de la tecnología en los gobiernos, en los usuarios y en los creadores mismos de este tipo de software. «Esto debe ser algo de lo que se hable en los estados, en la academias, en los ministerios, porque hay que establecer límites. Para ello no siempre la solución son leyes o prohibiciones. También necesitamos educación para que los usuarios entiendan qué derechos se vulneran con el uso de estas tecnologías», puntualizó.

FUENTE: Eltiempo.com