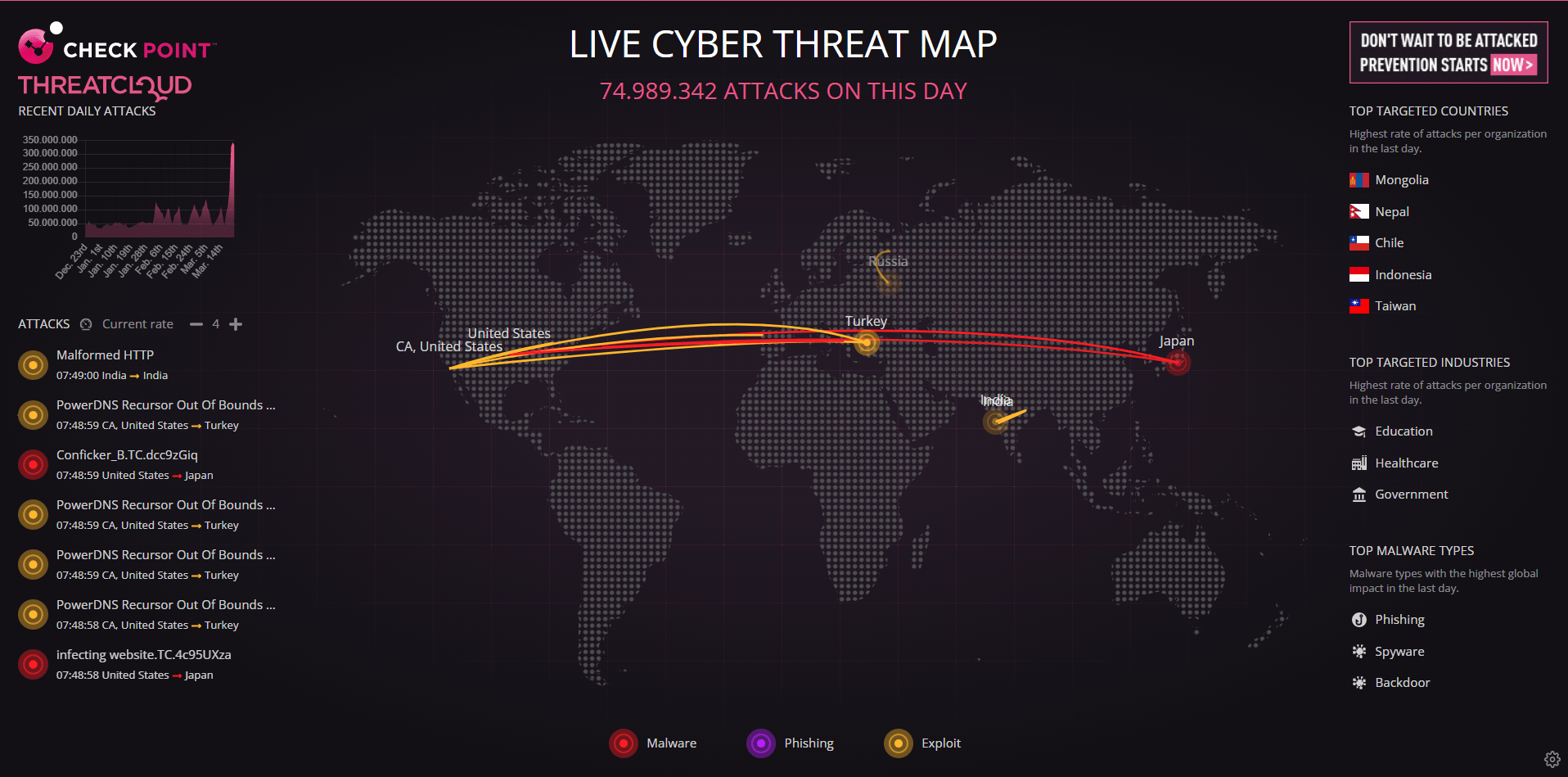

El malware, el phishing y la ingeniería social encabezan las técnicas más utilizadas por la nueva generación de ciberdelincuentes que, gracias a la ayuda de la IA, continúan creando unos ataques cada vez más frecuentes y efectivos.

Utilizado diariamente por millones de usuarios de todo el mundo, ChatGPT es un potente modelo de lenguaje que puede ser utilizado para facilitar algunas tareas diarias permitiendo generar y crear todo tipo de documentos e incluso traducir textos a otros idiomas en cuestión de segundos. Sin embargo, la neutralidad y falta de una verdadera consciencia de esta IA provoca que este gran potencial también puede ser utilizado para hacer el mal.

Desde su apertura al público el pasado año, Check Point® ha detectado ya numerosos ejemplos de cómo los ciberdelincuentes han estado usando ChatGPT para acelerar y mejorar sus campañas y herramientas de ciberataques, suponiendo ya una problemática para los principales desarrolladores de IA. Ante esta situación, Check Point Software ha logrado sintetizar los siete principales peligros y malos usos de la inteligencia artificial generativa en el ámbito de la ciberseguridad:

Ya desde Julio pasado Checkpoint habia prevenido sobre la fuga de datos sensibles y confidenciales al utilizar aplicaciones de IA generativa. Como todas las tecnologías nuevas, ChatGPT, Google Bard, Microsoft Bing Chat y otros servicios de IA generativa vienen con compensaciones clásicas, que incluyen innovación y ganancias de productividad versus seguridad de los datos. Afortunadamente, existen medidas sencillas que las organizaciones pueden tomar para protegerse inmediatamente contra la filtración involuntaria de información confidencial o sensible por parte de los empleados que utilizan estas nuevas aplicaciones. El uso de modelos de lenguaje grande (LLM) como ChatGPT se ha vuelto muy popular entre los empleados, por ejemplo, cuando buscan orientación rápida o ayuda con el desarrollo de código de software. Desafortunadamente, estas herramientas de ‘productividad’ a escala web también están perfectamente configuradas para convertirse en la mayor fuente de filtraciones accidentales de datos comerciales confidenciales en la historia, por un orden de magnitud. El uso de herramientas como ChatGPT o Bard hace que sea increíblemente fácil enviar inadvertidamente información confidencial o protegida por privacidad como parte de sus consultas. Muchos servicios de IA afirman que no almacenan en caché la información enviada ni utilizan los datos cargados para entrenar sus motores de IA. Pero ha habido múltiples incidentes específicamente con ChatGPT que han expuesto vulnerabilidades en el sistema. El equipo de ChatGPT solucionó recientemente una vulnerabilidad clave que exponía información personal, incluidos detalles de tarjetas de crédito y mensajes de chat. Check Point Software, un proveedor de seguridad líder a nivel mundial, proporciona indicadores y filtros de seguridad específicos de ChatGPT/Bard para bloquear la carga de datos confidenciales o protegidos a través de estos servicios en la nube de IA. Check Point permite a las organizaciones evitar el uso indebido de la IA generativa mediante el uso de control de aplicaciones y filtrado de URL para identificar y bloquear el acceso para bloquear el uso de estas aplicaciones, y prevención de pérdida de datos (DLP) para evitar la fuga de datos involuntaria mientras se usan estas aplicaciones.

- Distribución de malware: al aprovecharse del objetivo principal de estas herramientas, que buscan ayudar a los usuarios, los ciberdelincuentes generan elementos como virus o troyanos. Unos códigos maliciosos depurados que se incrustan en documentos, correos electrónicos e incluso páginas web para maximizar el alcance de sus ataques e infectar los ordenadores de sus víctimas.

- Phishing: con una gran cantidad de ejemplos disponibles, la IA permite crear unas comunicaciones falsas mucho más realistas y convincentes que hacen que la tarea de distinguir los verdaderos correos legítimos se convierta en un verdadero reto. Y es que el objetivo de estos no es otro que engañar a los usuarios para hacer que se sientan seguros y proporcionen información sensible como contraseñas o datos de pago como tarjetas de crédito.

- Ingeniería social: diseñadas para ser lo más humano posible, ChatGPT puede ser utilizado para hacerse pasar por personas reales con el fin de manipular a los usuarios para que realicen acciones perjudiciales para ellos mismos o sus empresas, engañar a un usuario para que proporcione información de su cuenta.

- Filtración y robo de datos: la IA generativa puede ser utilizada para crear documentos o correos electrónicos falsos que parecen legítimos, lo que puede ser utilizado para engañar a los usuarios y hacer que revelen sus credenciales o datos sensibles.

- Desinformación y propaganda: ChatGPT puede ser utilizado para generar noticias falsas y propaganda que pueden ser utilizadas para engañar y manipular a las personas. Esto puede ser usado para dañar reputaciones, sembrar discordia, e incluso incitar a la violencia.

- Difamación y suplantación: con herramientas como estas, cada vez más accesibles y asequibles, hay una creciente preocupación de que distinguir entre archivos auténticos y deep fakes sea casi imposible, capaces de crear fotografías, vídeos e incluso audios falsos.

- Amenazas internas: la inteligencia artificial puede ser utilizada maliciosamente para crear documentos o correos electrónicos falsos que aparentan provenir de usuarios autorizados, lo que puede ser utilizado para obtener acceso a datos o sistemas sensibles.

“Para mitigar los riesgos de la inteligencia artificial en ciberseguridad, es esencial implementar medidas de detección avanzadas que identifiquen la actividad maliciosa antes de que ocurran los ataques”, explica Manuel Rodríguez, Gerente de Ingeniería de Seguridad para el Norte de América Latina de Check Point Software. “Es necesario que se establezcan unas regulaciones y estándares para garantizar un uso ético de la IA, promoviendo la transparencia y responsabilidad en su desarrollo y aplicación”.

Para contrarrestar los peligros que la inteligencia artificial plantea en el ámbito de la ciberseguridad, se requiere un enfoque holístico que combine la tecnología avanzada, la educación de los usuarios, la regulación efectiva y la colaboración continua entre expertos.

Si bien la IA todavía cuenta con un gran potencial de desarrollo, es importante que la colaboración entre expertos en ciberseguridad y desarrolladores de estas herramientas se convierta en uno de los cimientos esenciales para anticipar y abordar los posibles riesgos emergentes.