Cuando hablamos de ciberseguridad, la imagen típica que se nos viene a la mente es la del atacante externo: un hacker encapuchado que busca vulnerar nuestros sistemas. Pero en 2025, el mayor riesgo no proviene de afuera… sino de adentro. Y no se llama ransomware. Se llama Shadow AI.

¿Qué es el Shadow AI?

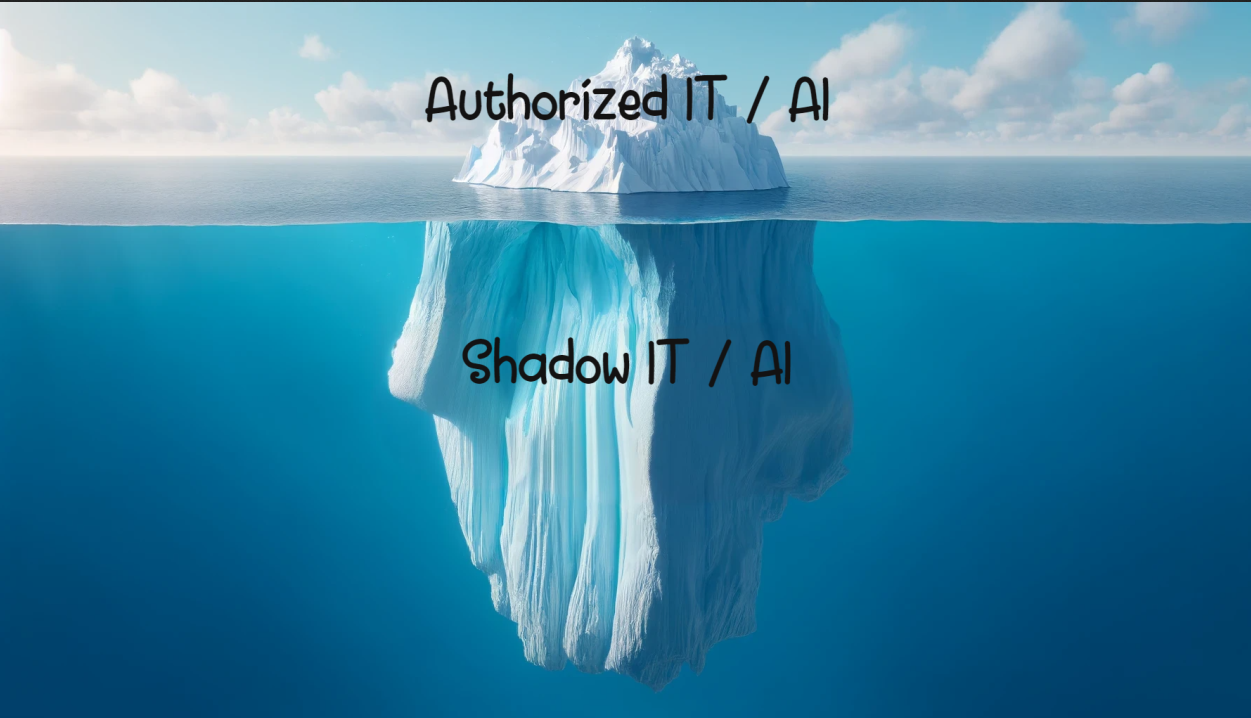

El término Shadow AI describe el uso no autorizado de herramientas de inteligencia artificial por parte de empleados, sin la supervisión ni el consentimiento del área de TI o de seguridad de la organización. A diferencia del Shadow IT, que hace referencia a tecnologías no aprobadas, el Shadow AI es más peligroso por su aparente inocuidad y su rápido impacto.

Ejemplos cotidianos que ya ocurren:

-

Un gerente que copia contratos confidenciales en un chatbot para pedir un resumen.

-

Un desarrollador que sube código fuente propietario a copilots gratuitos.

-

Un equipo de marketing que entrena un modelo externo con datos reales de clientes.

Todo esto ocurre fuera del radar corporativo… y cada acción deja una puerta abierta.

¿Por qué representa una amenaza crítica?

Aunque muchas de estas prácticas parten de una buena intención —agilizar tareas, aumentar la productividad, innovar— sus consecuencias pueden ser devastadoras:

-

Fuga de información sensible: Muchos proveedores de IA utilizan los datos ingresados para reentrenar sus modelos, lo que puede comprometer secretos comerciales, contratos, algoritmos o estrategias.

-

Incumplimiento regulatorio: Normativas como el GDPR (Europa), DORA (sector financiero) o BCRA (Argentina) pueden aplicar sanciones millonarias por exposición indebida de datos personales o confidenciales.

-

Pérdida de propiedad intelectual: Una vez que tus datos entrenan un modelo que no controlas, se diluye la propiedad. Tus diseños, fórmulas o ideas podrían terminar reutilizados sin tu consentimiento.

-

Salidas no auditables: Las respuestas generadas por IA no siempre pueden ser verificadas, lo que aumenta el riesgo de decisiones basadas en información errónea o manipulada.

¿Por qué el Shadow AI está creciendo tan rápido?

Porque la productividad es inmediata. Las herramientas de IA permiten realizar tareas en minutos que antes tomaban horas. Ante la presión por entregar resultados, muchos empleados optan por soluciones inmediatas, aunque sean inseguras, especialmente si la empresa no les ofrece una alternativa aprobada o guiada.

Este es el dilema actual: Prohibir la IA no es realista. Ignorarla, es suicida.

¿Cómo combatir el Shadow AI con inteligencia?

La solución no está en bloquear, sino en gobernar su uso de forma estratégica. Aquí algunas acciones clave para recuperar el control:

1. Políticas claras y actualizadas

Establecer qué datos pueden o no ingresarse en herramientas de IA externas. Clasificar la información y entrenar a los equipos sobre riesgos reales.

2. Modelos corporativos aprobados

Ofrecer herramientas internas o versiones privadas de modelos generativos (como LLMs on-premise o mediante nubes seguras) para evitar que los usuarios migren a soluciones públicas no controladas.

3. Monitoreo inteligente con DLP y CASB

Implementar soluciones de Prevención de Pérdida de Datos (DLP) y Cloud Access Security Brokers (CASB) para detectar usos indebidos de IA y frenar la salida de datos sensibles desde prompts.

4. Gobernanza de IA

Formar un comité de gobernanza donde participen Seguridad de la Información (CISO), Compliance, Legal y áreas de negocio. Este comité debe definir las reglas del juego, auditar usos y evaluar nuevas herramientas antes de su adopción.

Conclusión: el futuro ya llegó

El Shadow AI ya está dentro de tu organización, aunque no lo veas. Lo están usando gerentes, desarrolladores, analistas y equipos creativos. Y no necesariamente con malas intenciones. Pero el riesgo es real.

Desde Informática Forense, hacemos un llamado urgente a las empresas: no esperen un incidente para actuar. Gobernar la IA hoy es proteger el negocio mañana.